Chi tiết cấu hình môi trường:

Hệ điều hành: Redhat Enterprise Linux 8.4 64 Bit

Phiên bản phần mềm Oracle và Grid: 21.0.0.0 RAC: CÓ

Phiên bản phần mềm Oracle và Grid: 21.0.0.0 RAC: CÓ

Có thể cắm thêm: Không

Những điểm cần kiểm tra trước khi bắt đầu cài đặt RAC:

1) Tôi có đang tải xuống phần mềm GRID và Oracle DB đúng phiên bản không?

2) GRID và cơ sở dữ liệu của tôi có được chứng nhận trên hệ điều hành hiện tại

không?

2) GRID và cơ sở dữ liệu của tôi có được chứng nhận trên hệ điều hành hiện tại

không?

3) Kiến trúc phần mềm GRID và cơ sở dữ liệu của tôi là 32 bit hay 64 bit?

4) Kiến trúc hệ điều hành là 32 bit hay 64 bit?

4) Kiến trúc hệ điều hành là 32 bit hay 64 bit?

5) Phiên bản nhân hệ điều hành có tương thích với phần mềm cần cài đặt không?

6) Máy chủ của tôi đang ở cấp độ hoạt động 3 hay 5?

7) Đảm bảo có ít nhất 8 GB RAM trống để cài đặt Oracle Grid Infrastructure.

8) Oracle đặc biệt khuyến nghị nên tắt Transparent HugePages và sử dụng HugePages tiêu chuẩn để nâng cao hiệu suất.

9) Để cài đặt Oracle RAC 21c, bạn phải cài đặt Oracle Grid Infrastructure (Oracle Clusterware và Oracle ASM) 21c trên cụm máy chủ của mình.

10) Phiên bản Oracle Clusterware phải bằng hoặc lớn hơn phiên bản Oracle RAC mà bạn dự định cài đặt.

11) Sử dụng phần cứng máy chủ giống hệt nhau trên mỗi nút để đơn giản hóa việc bảo trì máy chủ.

Các bước cài đặt và cấu hình Oracle 21c Grid Infrastructure -- Phần I

Bước 1: Ma trận chứng nhận

Oracle Real Application Clusters 21.0.0.0.0 đã được chứng nhận trên Linux x86-64 Red Hat Enterprise Linux 8 Update 2+

RHEL 8.2 với phiên bản kernel: 4.18.0-193.19.1.el8_2.x86_64 trở lên

Khả năng tương thích 32/64 bit:

- Oracle Real Application Clusters 21.0.0.0 64 Bit tương thích với Linux x86-64 Red Hat Enterprise Linux 8 64 Bit.

- Oracle Real Application Clusters 21.0.0.0 64 Bit không tương thích với Linux x86-64 Red Hat Enterprise Linux 8 32 Bit.

Bước 2: Cấu hình máy chủ

- Cần ít nhất 1 GB dung lượng trống trong thư mục dung lượng đĩa tạm thời (/tmp).

- Không gian trao đổi:

- Từ 4 GB đến 16 GB: Tương đương với RAM

- Hơn 16 GB: 16 GB

Nếu bạn bật HugePages cho máy chủ Linux của mình, thì bạn nên trừ dung lượng bộ nhớ được phân bổ cho HugePages khỏi RAM khả dụng trước khi tính toán dung lượng swap.

- Phân bổ bộ nhớ cho HugePages đủ lớn cho các Vùng Toàn cục Hệ thống (SGA) của tất cả các cơ sở dữ liệu dự kiến chạy trên cụm, và để chứa Vùng Toàn cục Hệ thống cho Kho lưu trữ Quản lý Cơ sở hạ tầng Lưới.

- Oracle Clusterware yêu cầu thiết lập biến môi trường múi giờ giống nhau trên tất cả các nút cụm. Hãy đảm bảo rằng bạn thiết lập đồng bộ hóa múi giờ trên tất cả các nút cụm bằng cách sử dụng giao thức thời gian mạng (NTP) được cấu hình bởi hệ điều hành hoặc Dịch vụ Đồng bộ hóa Thời gian Cụm Oracle.

- Theo mặc định, hệ điều hành của bạn bao gồm một mục trong /etc/fstab để gắn kết /dev/shm. Hãy đảm bảo rằng vùng gắn kết /dev/shm có kiểu tmpfs và được gắn kết với các tùy chọn sau:

- đã thiết lập quyền đọc và thực thi cho nó.

- Nếu không có thiết lập noexec hoặc nosuid thì sẽ không được bật.

- Thư mục Oracle home hoặc Oracle base không thể là liên kết tượng trưng, cũng như bất kỳ thư mục cha nào của chúng, cho đến tận thư mục gốc.

Mạng công cộng:

- Bộ chuyển mạch mạng công cộng được kết nối với cổng mạng công cộng và các cổng giao diện công cộng cho mỗi nút thành viên của cụm (khuyến nghị sử dụng bộ chuyển mạch dự phòng).

- Card giao diện Ethernet (khuyến nghị sử dụng các card mạng dự phòng, được ghép nối thành một tên cổng Ethernet duy nhất).

- Các thiết bị chuyển mạch và giao diện mạng phải có tốc độ tối thiểu 1 GbE.

- Giao thức mạng là Giao thức điều khiển truyền dẫn (TCP) và Giao thức Internet (IP).

Phần cứng mạng riêng cho kết nối liên mạng:

- Các bộ chuyển mạch mạng riêng biệt (khuyến nghị sử dụng bộ chuyển mạch dự phòng), được kết nối với các cổng giao diện riêng cho mỗi nút thành viên của cụm. Nếu bạn có nhiều hơn một card giao diện mạng riêng cho mỗi máy chủ, thì Oracle Clusterware sẽ tự động liên kết các giao diện này cho mạng riêng bằng cách sử dụng Giao tiếp liên tiến trình lưới (GIPC) và Kết nối dự phòng cơ sở hạ tầng lưới, còn được gọi là IP khả dụng cao của cụm (HAIP).

- Các thiết bị chuyển mạch và bộ điều hợp giao diện mạng phải có tốc độ tối thiểu 1 GbE.

- Hệ thống kết nối liên mạng phải hỗ trợ giao thức datagram người dùng (UDP) .

- Khung Jumbo (khung Ethernet lớn hơn 1500 bit) không phải là tiêu chuẩn IEEE, nhưng có thể giảm chi phí UDP nếu được cấu hình đúng cách. Oracle khuyến nghị sử dụng khung Jumbo cho các kết nối liên mạng. Tuy nhiên, cần lưu ý rằng bạn phải kiểm tra tải hệ thống và đảm bảo rằng chúng được bật trên toàn bộ hệ thống.

Phần cứng mạng Oracle Flex ASM:

- Oracle Flex ASM có thể sử dụng cùng mạng riêng với Oracle Clusterware hoặc sử dụng mạng riêng chuyên dụng của mình. Mỗi mạng có thể được phân loại là PUBLIC, PRIVATE+ASM, PRIVATE hoặc ASM. Mạng Oracle ASM sử dụng giao thức TCP.

Đối với cấu hình RAC 2 nút:

- 2 địa chỉ IP công cộng (public)

- 2 địa chỉ IP riêng (private)

- 2 địa chỉ IP ảo (public)

- 1 hoặc 3 địa chỉ IP scan (Nếu là 1 thì ghi rõ trong file /etc/hosts, nếu là 3 thì dùng DNS để phân vùng luân phiên)

Ở đây, tôi đã sử dụng dãy địa chỉ IP dưới đây cho cấu hình RAC 2 nút.

Lưu ý rằng các dòng địa chỉ IP Public, VIP và SCAN là giống nhau, còn dòng địa chỉ IP Private thì khác với các dòng Public, VIP và SCAN. Tuy nhiên, các dòng Public, VIP và SCAN có thể khác nhau.

- Mỗi nút phải có ít nhất hai bộ điều hợp mạng: một cho giao diện mạng công cộng (TCP/IP) và một cho kết nối liên mạng riêng (UDP).

- Để cải thiện tính khả dụng, có thể cấu hình các bộ điều hợp mạng công cộng và riêng tư dự phòng cho mỗi nút.

- Tên giao diện được liên kết với (các) bộ điều hợp mạng cho mỗi mạng phải giống nhau trên tất cả các nút. Ví dụ: nếu eth1 được sử dụng cho mạng công cộng trên nút thứ nhất thì eth1 cũng phải được sử dụng cho mạng công cộng trên nút thứ hai. Bạn không thể sử dụng eth1 cho mạng Ethernet riêng.

- Địa chỉ IP ảo và tên mạng không được phép đang được sử dụng.

- Địa chỉ IP ảo phải nằm trên cùng một mạng con với địa chỉ IP công cộng của bạn.

#Public IP 10.20.30.101 rac1.localdomain rac1 10.20.30.102 rac2.localdomain rac2 #Private IP 10.1.2.201 rac1-priv.localdomain rac1-priv 10.1.2.202 rac2-priv.localdomain rac2-priv #VIP IP 10.20.30.103 rac1-vip.localdomain rac1-vip 10.20.30.104 rac2-vip.localdomain rac2-vip #scan IP 10.20.30.105 rac-scan.localdomain rac-scan |

Cấu hình lưu trữ:

Cần tối thiểu 12 GB dung lượng cho Oracle Grid Infrastructure cho thư mục cài đặt cụm (Grid home). Oracle khuyến nghị nên phân bổ 100 GB để có thêm dung lượng cho các bản vá lỗi. Cần tối thiểu 10 GB cho Oracle Database Enterprise Edition.

Bắt đầu từ Oracle Grid Infrastructure 19c, việc cấu hình GIMR là tùy chọn đối với các triển khai Oracle Standalone Cluster.

Để cài đặt, hãy cấu hình yêu cầu dung lượng ổ đĩa tối thiểu:

- 100 GB trên mỗi nút - bộ nhớ cục bộ /u01 để lưu trữ các tệp nhị phân GRID và ORACLE

- 20 GB trên mỗi nút - bộ nhớ cục bộ /osw để lưu trữ nhật ký oswatcher (Tùy chọn)

- 3 ổ đĩa 10 GB để lưu trữ các tệp OCR và tệp bỏ phiếu - lưu trữ dùng chung trong trường hợp dự phòng thông thường. Nếu bạn sử dụng mức dự phòng cao thì hãy sử dụng 5 ổ đĩa 10 GB.

Bước 3: Tải xuống phần mềm

Bước 4: Cấu hình máy ảo

Nhấp vào tab "Mới" .

Bạn sẽ thấy hộp thoại bật lên bên dưới, hãy chỉnh sửa thông tin chi tiết và giữ nguyên như hình bên dưới.

Trong phần cài đặt bộ nhớ, tôi chỉ khai báo 6 GB. Bạn có thể thêm nhiều bộ nhớ hơn cho môi trường sản xuất thực tế.

Nhấp vào tab "Tạo ổ cứng ảo ngay bây giờ" .

Nhấp vào tab "VDI (Virtual Box Disk Image)" .

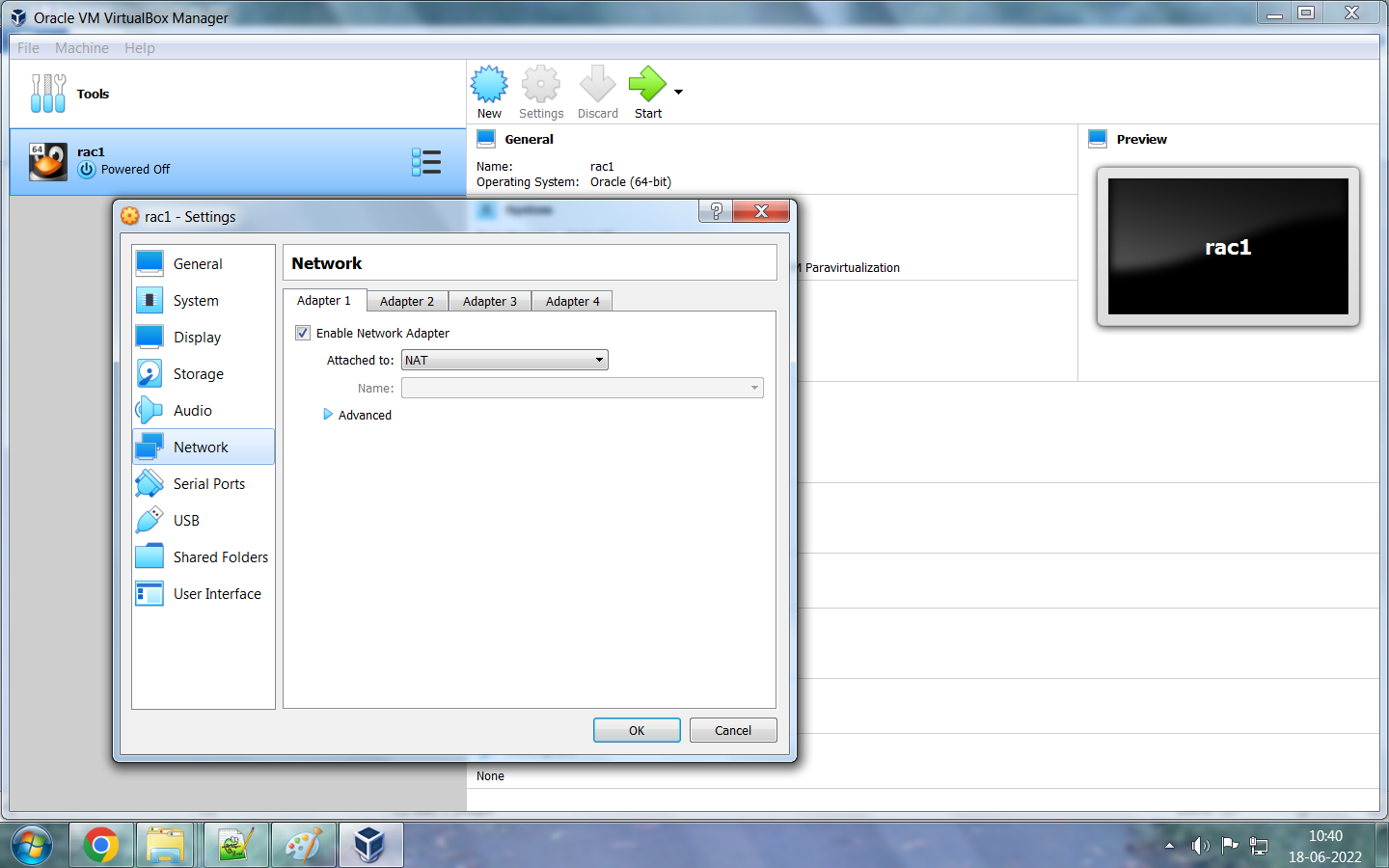

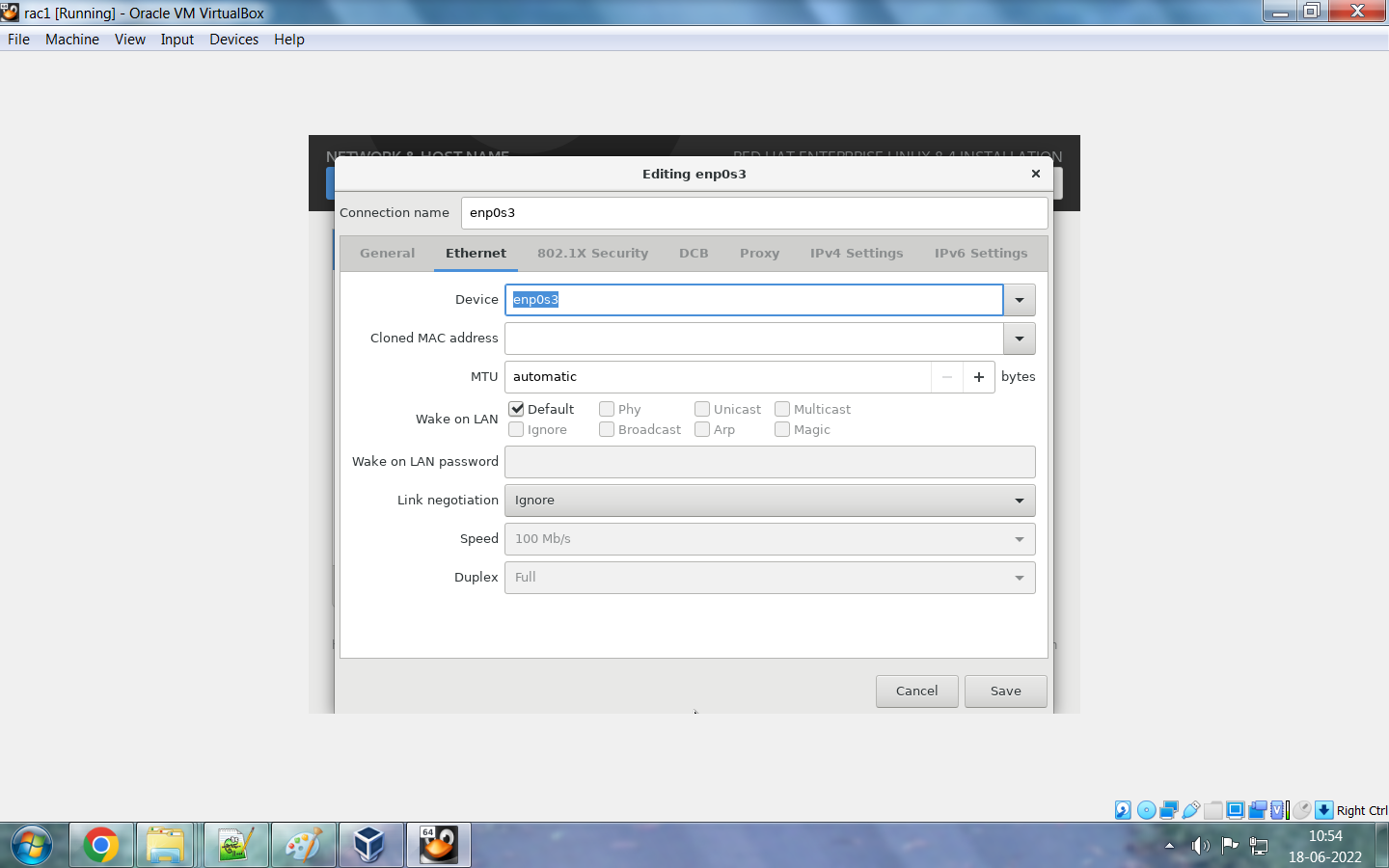

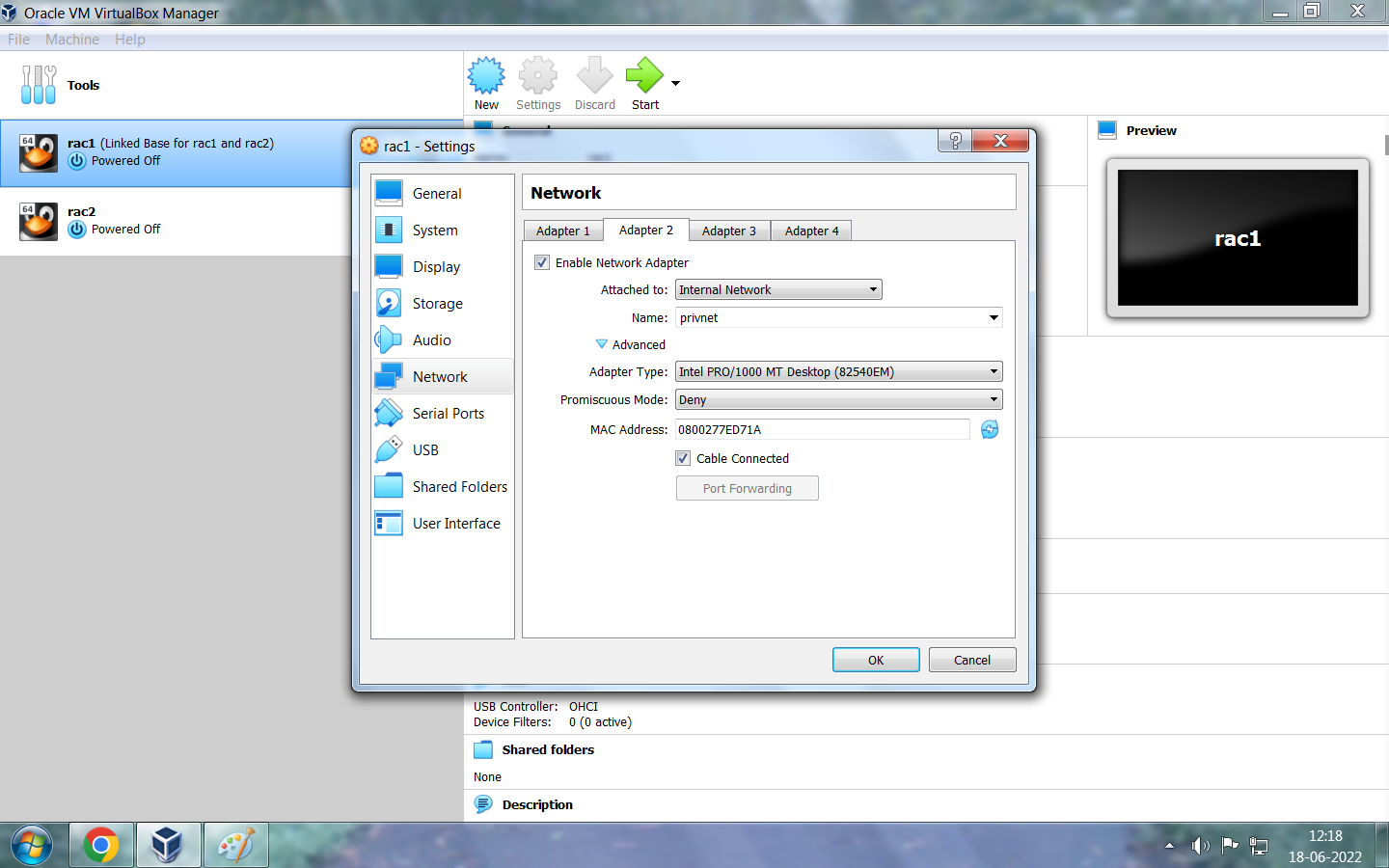

Nhấp vào Xác định mạng công cộng là pubnet và mạng Ethernet riêng là privnet .

Đối với Node1: pubnet và privnet

Đối với Node2: pubnet và privnet

Ở đây, tôi đã sử dụng các địa chỉ IP bên dưới cho mạng Ethernet công cộng và riêng tư. Ngoài ra, hãy thêm tên máy chủ cho node1. Chúng ta sẽ thêm địa chỉ IP của node thứ 2 sau bằng quy trình sao chép.

#Public IP

10.20.30.101 rac1.localdomain rac1

10.20.30.102 rac2.localdomain rac2

#Private IP

10.1.2.201 rac1-priv.localdomain rac1-priv

10.1.2.202 rac2-priv.localdomain rac2-privNhấp vào tùy chọn "BẬT" rồi chọn "Xong" . Trạng thái mạng của cả hai bộ chuyển đổi sẽ hiển thị là " đã kết nối ".

Bước 6: Thực hiện kiểm tra sau khi lắp đặt.

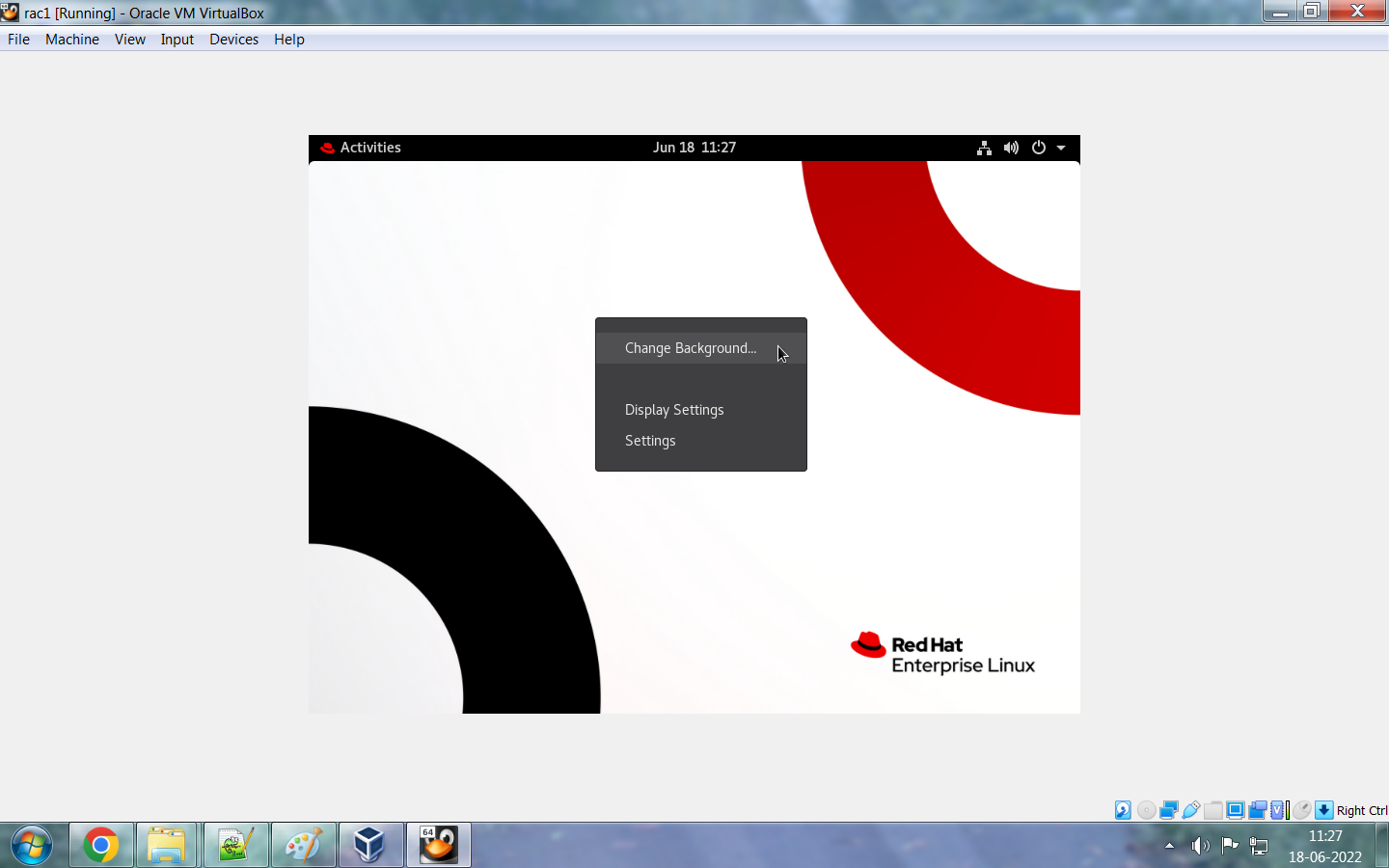

Nhấp vào tùy chọn "Chèn ảnh đĩa CD Guest Additions" để sao chép/dán dữ liệu và kéo/thả tệp từ máy tính để bàn của bạn sang máy ảo VDI và ngược lại. Hệ thống sẽ yêu cầu thông tin đăng nhập người dùng root hoặc bạn cần đăng nhập với tư cách người dùng root để thực hiện thao tác này.

Giờ là lúc thực hiện các thay đổi ở cấp độ máy chủ. Hãy thực hiện các bước kiểm tra dưới đây sau khi cài đặt hệ điều hành.

- Cập nhật tệp /etc/hosts

- Dừng và tắt tường lửa.

- Vô hiệu hóa SELINUX

- Tạo cấu trúc thư mục

- Tạo người dùng và nhóm kèm quyền hạn

- Thêm các giới hạn và tham số kernel vào tệp cấu hình.

Hãy thực hiện các thay đổi trên máy chủ chính rồi sao chép máy ảo; nếu không, bạn cũng phải thực hiện các thay đổi trên máy chủ đã sao chép.

/etc/hosts file entry for both Nodes: #Public IP 10.20.30.101 rac1.localdomain rac1 10.20.30.102 rac2.localdomain rac2 #Private IP 10.1.2.201 rac1-priv.localdomain rac1-priv 10.1.2.202 rac2-priv.localdomain rac2-priv #VIP IP 10.20.30.103 rac1-vip.localdomain rac1-vip 10.20.30.104 rac2-vip.localdomain rac2-vip #scan IP 10.20.30.105 rac-scan.localdomain rac-scan Lệnh để view/stop/disable firewall: #systemctl status firewalld #systemctl stop firewalld #systemctl disable firewalld #systemctl status firewalld Lệnh để view/stop/disable firewall: #systemctl status firewalld User và group với quyền: [root@rac1 ~]# groupadd -g 2000 oinstall [root@rac1 ~]# groupadd -g 2100 asmadmin [root@rac1 ~]# groupadd -g 2200 dba [root@rac1 ~]# groupadd -g 2300 oper [root@rac1 ~]# groupadd -g 2400 asmdba [root@rac1 ~]# groupadd -g 2500 asmoper [root@rac1 /]# useradd grid [root@rac1 /]# useradd oracle [root@rac1 /]# passwd grid Changing password for user grid. New password: BAD PASSWORD: The password is shorter than 8 characters Retype new password: passwd: all authentication tokens updated successfully. [root@rac1 /]# [root@rac1 /]# passwd oracle Changing password for user oracle. New password: BAD PASSWORD: The password is shorter than 8 characters Retype new password: passwd: all authentication tokens updated successfully. [root@rac1 /]# usermod -g oinstall -G asmadmin,dba,oper,asmdba,asmoper grid [root@rac1 /]# usermod -g oinstall -G asmadmin,dba,oper,asmdba,asmoper oracle [root@rac1 /]# id grid uid=1001(grid) gid=2000(oinstall) groups=2000(oinstall),2100(asmadmin),2200(dba),2300(oper),2400(asmdba),2500(asmoper) [root@rac1 /]# id oracle uid=1002(oracle) gid=2000(oinstall) groups=2000(oinstall),2100(asmadmin),2200(dba),2300(oper),2400(asmdba),2500(asmoper) Tạo cấu trúc thư mục: [root@rac1 /]# mkdir -p /u01/app/grid [root@rac1 /]# mkdir -p /u01/app/21.0.0/grid [root@rac1 /]# mkdir -p /u01/app/oraInventory [root@rac1 /]# mkdir -p /u01/app/oracle [root@rac1 /]# chown -R grid:oinstall /u01/app/grid [root@rac1 /]# chown -R grid:oinstall /u01/app/21.0.0/grid [root@rac1 /]# chown -R grid:oinstall /u01/app/oraInventory [root@rac1 /]# chown -R oracle:oinstall /u01/app/oracle [root@rac1 /]# chmod -R 755 /u01/app/grid [root@rac1 /]# chmod -R 755 /u01/app/21.0.0/grid [root@rac1 /]# chmod -R 755 /u01/app/oraInventory [root@rac1 /]# chmod -R 755 /u01/app/oracle Thêm tham số cấu hình kernel và limits : [root@rac1 /]# vi /etc/sysctl.conf fs.file-max = 6815744 kernel.sem = 250 32000 100 128 kernel.shmmni = 4096 kernel.shmall = 1073741824 kernel.shmmax = 4398046511104 kernel.panic_on_oops = 1 net.core.rmem_default = 262144 net.core.rmem_max = 4194304 net.core.wmem_default = 262144 net.core.wmem_max = 1048576 net.ipv4.conf.all.rp_filter = 2 net.ipv4.conf.default.rp_filter = 2 fs.aio-max-nr = 1048576 net.ipv4.ip_local_port_range = 9000 65500 Apply thay đổi root@rac1 /]# sysctl -p [root@rac1 /]# vi /etc/security/limits.conf oracle soft nofile 1024 oracle hard nofile 65536 oracle soft nproc 16384 oracle hard nproc 16384 oracle soft stack 10240 oracle hard stack 32768 oracle hard memlock 134217728 oracle soft memlock 134217728 oracle soft data unlimited oracle hard data unlimited grid soft nofile 1024 grid hard nofile 65536 grid soft nproc 16384 grid hard nproc 16384 grid soft stack 10240 grid hard stack 32768 grid hard memlock 134217728 grid soft memlock 134217728 grid soft data unlimited grid hard data unlimited [root@rac1 /]# cat /etc/security/limits.conf | grep -v "#" |

Chuột phải vào máy ảo --> Cone

Đổi tên máy ảo thành rac2 với tùy chọn "Generate new mac addresses for all network adapters". Thao tác này sẽ loại bỏ nhu cầu phải thêm địa chỉ MAC thủ công sau khi sao chép máy.

Trong các phiên bản Virtual Box trước đây, chúng ta phải tự thay đổi địa chỉ MAC của máy chủ nhân bản, nhưng giờ đây chúng ta có tùy chọn tạo địa chỉ MAC mới trong quá trình nhân bản máy chủ.

|

Nhấp vào "File" rồi chọn "Virtual Media Manager" .

Nhấp vào tùy chọn "Create" để tạo 3 đĩa OCR phục vụ mục đích cài đặt nhằm đảm bảo tính dự phòng thông thường.

- ocr1 - 10 GB

- ocr2 - 10 GB

- ocr3 - 10 GB

Tiếp tục vào "Tệp" rồi chọn "Trình quản lý phương tiện ảo" . Nhấp vào từng ổ đĩa OCR và đánh dấu 3 ổ đĩa OCR là "Có thể chia sẻ" .

Bạn có thể kiểm tra xem tất cả các ổ đĩa đã hiển thị trên màn hình bên dưới cho cả hai nút hay chưa.

- oracleasmlib

- hỗ trợ oracleasm

- kmod ----- Chỉ dành cho Redhat Linux

Dưới đây là một vài liên kết để tải xuống các gói oracleasm và kmod.

- Bạn có thể tải xuống gói oracleasmlib từ https://www.oracle.com/linux/downloads/linux-asmlib-v8-downloads.html

- Link tải xuống gói RPM "oracleasm-support": https://public-yum.oracle.com/repo/OracleLinux/OL8/addons/x86_64/index.html

- Link tải gói kmod : https://public-yum.oracle.com/oracle-linux-8.html

# Thực hiện các lệnh bên dưới để cài đặt gói RPM "libnsl" trên cả hai nút . [root@rac1 grid]# cd /media/ [root@rac1 media]# ll total 12 drwxrwx--- 1 root vboxsf 4096 Jun 18 14:42 sf_RHEL_8.4_64-bit drwxrwx--- 1 root vboxsf 8192 Jun 6 18:37 sf_Software [root@rac1 media]# cd sf_RHEL_8.4_64-bit/ [root@rac1 sf_RHEL_8.4_64-bit]# ll drwxrwx--- 1 root vboxsf 0 May 4 2021 AppStream drwxrwx--- 1 root vboxsf 0 May 4 2021 BaseOS drwxrwx--- 1 root vboxsf 0 May 4 2021 EFI -rwxrwx--- 1 root vboxsf 8154 May 4 2021 EULA -rwxrwx--- 1 root vboxsf 1455 May 4 2021 extra_files.json -rwxrwx--- 1 root vboxsf 18092 May 4 2021 GPL drwxrwx--- 1 root vboxsf 0 May 4 2021 images drwxrwx--- 1 root vboxsf 4096 May 4 2021 isolinux -rwxrwx--- 1 root vboxsf 103 May 4 2021 media.repo -rwxrwx--- 1 root vboxsf 10130292736 Sep 25 2021 rhel-8.4-x86_64-dvd.iso -rwxrwx--- 1 root vboxsf 1669 May 4 2021 RPM-GPG-KEY-redhat-beta -rwxrwx--- 1 root vboxsf 5134 May 4 2021 RPM-GPG-KEY-redhat-release -rwxrwx--- 1 root vboxsf 1796 May 4 2021 TRANS.TBL [root@rac1 sf_RHEL_8.4_64-bit]# pwd /media/sf_RHEL_8.4_64-bit [root@rac1 sf_RHEL_8.4_64-bit]# cp media.repo /etc/yum.repos.d/rhel7dvd.repo [root@rac1 sf_RHEL_8.4_64-bit]# vi /etc/yum.repos.d/rhel7dvd.repo [root@rac1 sf_RHEL_8.4_64-bit]# pwd /media/sf_RHEL_8.4_64-bit [root@rac1 sf_RHEL_8.4_64-bit]# ll drwxrwx--- 1 root vboxsf 0 May 4 2021 AppStream drwxrwx--- 1 root vboxsf 0 May 4 2021 BaseOS drwxrwx--- 1 root vboxsf 0 May 4 2021 EFI -rwxrwx--- 1 root vboxsf 8154 May 4 2021 EULA -rwxrwx--- 1 root vboxsf 1455 May 4 2021 extra_files.json -rwxrwx--- 1 root vboxsf 18092 May 4 2021 GPL drwxrwx--- 1 root vboxsf 0 May 4 2021 images drwxrwx--- 1 root vboxsf 4096 May 4 2021 isolinux -rwxrwx--- 1 root vboxsf 103 May 4 2021 media.repo -rwxrwx--- 1 root vboxsf 10130292736 Sep 25 2021 rhel-8.4-x86_64-dvd.iso -rwxrwx--- 1 root vboxsf 1669 May 4 2021 RPM-GPG-KEY-redhat-beta -rwxrwx--- 1 root vboxsf 5134 May 4 2021 RPM-GPG-KEY-redhat-release -rwxrwx--- 1 root vboxsf 1796 May 4 2021 TRANS.TBL [root@rac1 sf_RHEL_8.4_64-bit]# cd BaseOS/ [root@rac1 BaseOS]# pwd /media/sf_RHEL_8.4_64-bit/BaseOS [root@rac1 BaseOS]# ll drwxrwx--- 1 root vboxsf 1048576 May 4 2021 Packages drwxrwx--- 1 root vboxsf 4096 May 4 2021 repodata [root@rac1 BaseOS]# cd - /media/sf_RHEL_8.4_64-bit [root@rac1 sf_RHEL_8.4_64-bit]# vi /etc/yum.repos.d/rhel7dvd.repo [root@rac1 sf_RHEL_8.4_64-bit]# [root@rac1 sf_RHEL_8.4_64-bit]# cat /etc/yum.repos.d/rhel7dvd.repo [InstallMedia] name=Red Hat Enterprise Linux 8.4.0 mediaid=None metadata_expire=-1 gpgcheck=1 cost=500 enabled=1 baseurl=file:///media/sf_RHEL_8.4_64-bit/BaseOS gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release [root@rac1 sf_RHEL_8.4_64-bit]# chmod 644 /etc/yum.repos.d/rhel7dvd.repo [root@rac1 sf_RHEL_8.4_64-bit]# yum install libnsl Updating Subscription Management repositories. Unable to read consumer identity This system is not registered to Red Hat Subscription Management. You can use subscription-manager to register. Red Hat Enterprise Linux 8.4.0 104 MB/s | 2.3 MB 00:00 Dependencies resolved. ============================================================================================================================================================== Package Architecture Version Repository Size ============================================================================================================================================================== Installing: libnsl x86_64 2.28-151.el8 InstallMedia 102 k Transaction Summary ============================================================================================================================================================== Install 1 Package Total size: 102 k Installed size: 160 k Is this ok [y/N]: y Downloading Packages: warning: /media/sf_RHEL_8.4_64-bit/BaseOS/Packages/libnsl-2.28-151.el8.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID fd431d51: NOKEY Red Hat Enterprise Linux 8.4.0 459 kB/s | 5.0 kB 00:00 Importing GPG key 0xFD431D51: Userid : "Red Hat, Inc. (release key 2) <security@redhat.com>" Fingerprint: 567E 347A D004 4ADE 55BA 8A5F 199E 2F91 FD43 1D51 From : /etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release Is this ok [y/N]: y Key imported successfully Importing GPG key 0xD4082792: Userid : "Red Hat, Inc. (auxiliary key) <security@redhat.com>" Fingerprint: 6A6A A7C9 7C88 90AE C6AE BFE2 F76F 66C3 D408 2792 From : /etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release Is this ok [y/N]: y Key imported successfully Running transaction check Transaction check succeeded. Running transaction test Transaction test succeeded. Running transaction Preparing : 1/1 Installing : libnsl-2.28-151.el8.x86_64 1/1 Running scriptlet: libnsl-2.28-151.el8.x86_64 1/1 Verifying : libnsl-2.28-151.el8.x86_64 1/1 Installed products updated. Installed: libnsl-2.28-151.el8.x86_64 Complete! [root@rac2 sf_RHEL_8.4_64-bit]# cp media.repo /etc/yum.repos.d/rhel7dvd.repo [root@rac2 sf_RHEL_8.4_64-bit]# vi /etc/yum.repos.d/rhel7dvd.repo [root@rac2 sf_RHEL_8.4_64-bit]# cat /etc/yum.repos.d/rhel7dvd.repo [InstallMedia] name=Red Hat Enterprise Linux 8.4.0 mediaid=None metadata_expire=-1 gpgcheck=1 cost=500 enabled=1 baseurl=file:///media/sf_RHEL_8.4_64-bit/BaseOS gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release [root@rac2 sf_RHEL_8.4_64-bit]# chmod 644 /etc/yum.repos.d/rhel7dvd.repo [root@rac2 sf_RHEL_8.4_64-bit]# yum install libnsl Updating Subscription Management repositories. Unable to read consumer identity This system is not registered to Red Hat Subscription Management. You can use subscription-manager to register. Red Hat Enterprise Linux 8.4.0 120 MB/s | 2.3 MB 00:00 Dependencies resolved. ============================================================================================================================================================== Package Architecture Version Repository Size ============================================================================================================================================================== Installing: libnsl x86_64 2.28-151.el8 InstallMedia 102 k Transaction Summary ============================================================================================================================================================== Install 1 Package Total size: 102 k Installed size: 160 k Is this ok [y/N]: y Downloading Packages: warning: /media/sf_RHEL_8.4_64-bit/BaseOS/Packages/libnsl-2.28-151.el8.x86_64.rpm: Header V3 RSA/SHA256 Signature, key ID fd431d51: NOKEY Red Hat Enterprise Linux 8.4.0 257 kB/s | 5.0 kB 00:00 Importing GPG key 0xFD431D51: Userid : "Red Hat, Inc. (release key 2) <security@redhat.com>" Fingerprint: 567E 347A D004 4ADE 55BA 8A5F 199E 2F91 FD43 1D51 From : /etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release Is this ok [y/N]: y Key imported successfully Importing GPG key 0xD4082792: Userid : "Red Hat, Inc. (auxiliary key) <security@redhat.com>" Fingerprint: 6A6A A7C9 7C88 90AE C6AE BFE2 F76F 66C3 D408 2792 From : /etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release Is this ok [y/N]: y Key imported successfully Running transaction check Transaction check succeeded. Running transaction test Transaction test succeeded. Running transaction Preparing : 1/1 Installing : libnsl-2.28-151.el8.x86_64 1/1 Running scriptlet: libnsl-2.28-151.el8.x86_64 1/1 Verifying : libnsl-2.28-151.el8.x86_64 1/1 Installed products updated. Installed: libnsl-2.28-151.el8.x86_64 Complete! |

Cài đặt gói RPM " cvuqdisk" [grid@rac1 rpm]$ su - Password: [root@rac1 ~]# cd /u01/app/21.0.0/grid/cv cv/ cvu/ [root@rac1 ~]# cd /u01/app/21.0.0/grid/cv/r remenv/ rpm/ [root@rac1 ~]# cd /u01/app/21.0.0/grid/cv/rpm/ [root@rac1 rpm]# pwd /u01/app/21.0.0/grid/cv/rpm [root@rac1 rpm]# ll -rw-r--r-- 1 grid oinstall 11904 Jul 8 2021 cvuqdisk-1.0.10-1.rpm [root@rac1 rpm]# rpm -ivh cvuqdisk-1.0.10-1.rpm Verifying... ################################# [100%] Preparing... ################################# [100%] Using default group oinstall to install package Updating / installing... 1:cvuqdisk-1.0.10-1 ################################# [100%] [root@rac1 rpm]# scp cvuqdisk-1.0.10-1.rpm grid@rac2:/tmp/ The authenticity of host 'rac2 (10.20.30.102)' can't be established. ECDSA key fingerprint is SHA256:paSUsPHPoUwF04C4TJffskwngg82TS389hoEYRvbWJ4. Are you sure you want to continue connecting (yes/no/[fingerprint])? yes Warning: Permanently added 'rac2,10.20.30.102' (ECDSA) to the list of known hosts. grid@rac2's password: [root@rac1 rpm]# scp cvuqdisk-1.0.10-1.rpm grid@rac2:/tmp/^C [root@rac1 rpm]# scp cvuqdisk-1.0.10-1.rpm root@rac2:/tmp/ root@rac2's password: cvuqdisk-1.0.10-1.rpm 100% 12KB 14.6MB/s 00:00 [root@rac2 ~]# cd /tmp [root@rac2 tmp]# ll -rw-r--r--. 1 root root 2956 Jun 18 11:22 anaconda.log drwxr-x--- 3 grid oinstall 4096 Jun 18 23:11 CVU_21.0.0.0.0_grid -rw-r--r-- 1 root root 11904 Jun 18 23:13 cvuqdisk-1.0.10-1.rpm -rw-r--r--. 1 root root 2286 Jun 18 11:20 dbus.log -rw-r--r--. 1 root root 0 Jun 18 11:20 dnf.librepo.log drwxr-xr-x. 2 root root 19 Jun 18 11:10 hsperfdata_root -rwx------. 1 root root 701 Jun 18 11:19 ks-script-7ob6m6ob -rwx------. 1 root root 291 Jun 18 11:19 ks-script-9ryflhsk -rw-r--r--. 1 root root 0 Jun 18 11:20 packaging.log -rw-r--r--. 1 root root 131 Jun 18 11:20 program.log -rw-r--r--. 1 root root 0 Jun 18 11:20 sensitive-info.log drwx------ 3 root root 17 Jun 18 22:49 systemd-private-618118b2a7c04baca8d32b7487e3a26d-colord.service-Kt0f9i drwx------ 3 root root 17 Jun 18 23:13 systemd-private-618118b2a7c04baca8d32b7487e3a26d-fprintd.service-h0qY6i drwx------ 3 root root 17 Jun 18 22:55 systemd-private-618118b2a7c04baca8d32b7487e3a26d-fwupd.service-X9p7Kh drwx------ 3 root root 17 Jun 18 22:47 systemd-private-618118b2a7c04baca8d32b7487e3a26d-ModemManager.service-Mkm12g drwx------ 3 root root 17 Jun 18 22:47 systemd-private-618118b2a7c04baca8d32b7487e3a26d-rtkit-daemon.service-YUTjcf drwx------. 2 rupesh rupesh 6 Jun 18 14:52 tracker-extract-files.1000 drwx------ 2 grid oinstall 6 Jun 18 22:55 tracker-extract-files.1001 -rw-r--r--. 1 root root 25965 Jun 18 11:29 vboxguest-Module.symvers [root@rac2 tmp]# [root@rac2 tmp]# rpm -ivh cvuqdisk-1.0.10-1.rpm Verifying... ################################# [100%] Preparing... ################################# [100%] Using default group oinstall to install package Updating / installing... 1:cvuqdisk-1.0.10-1 ################################# [100%] |

Node1: [root@rac1 Oracle 21c]# oracleasm configure -i Configuring the Oracle ASM library driver. This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets ('[]'). Hitting <ENTER> without typing an answer will keep that current value. Ctrl-C will abort. Default user to own the driver interface []: grid Default group to own the driver interface []: oinstall Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y Writing Oracle ASM library driver configuration: done [root@rac1 Oracle 21c]# oracleasm init Creating /dev/oracleasm mount point: /dev/oracleasm Loading module "oracleasm": oracleasm Configuring "oracleasm" to use device physical block size Mounting ASMlib driver filesystem: /dev/oracleasm Node2: [root@rac2 Oracle 21c]# oracleasm configure -i Configuring the Oracle ASM library driver. This will configure the on-boot properties of the Oracle ASM library driver. The following questions will determine whether the driver is loaded on boot and what permissions it will have. The current values will be shown in brackets ('[]'). Hitting <ENTER> without typing an answer will keep that current value. Ctrl-C will abort. Default user to own the driver interface []: grid Default group to own the driver interface []: oinstall Start Oracle ASM library driver on boot (y/n) [n]: y Scan for Oracle ASM disks on boot (y/n) [y]: y Writing Oracle ASM library driver configuration: done [root@rac2 Oracle 21c]# oracleasm init Creating /dev/oracleasm mount point: /dev/oracleasm Loading module "oracleasm": oracleasm Configuring "oracleasm" to use device physical block size Mounting ASMlib driver filesystem: /dev/oracleasm |

Lưu ý: Phân vùng thiết bị từ bất kỳ một nút nào. Không cần phân vùng thiết bị trên tất cả các nút.

[rupesh@rac1 ~]$ su - Password: [root@rac1 ~]# fdisk -l Disk /dev/sdc: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk /dev/sda: 35 GiB, 37580963840 bytes, 73400320 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x81d908ce Device Boot Start End Sectors Size Id Type /dev/sda1 * 2048 2099199 2097152 1G 83 Linux /dev/sda2 2099200 73400319 71301120 34G 8e Linux LVM Disk /dev/sdb: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk /dev/sdd: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk /dev/mapper/rhel-root: 30.5 GiB, 32744931328 bytes, 63954944 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disk /dev/mapper/rhel-swap: 3.5 GiB, 3758096384 bytes, 7340032 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes [root@rac1 ~]# fdisk -l /dev/sdb Disk /dev/sdb: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes [root@rac1 ~]# fdisk -l /dev/sdc Disk /dev/sdc: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes [root@rac1 ~]# fdisk -l /dev/sdd Disk /dev/sdd: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes [root@rac1 ~]# fdisk /dev/sdb Welcome to fdisk (util-linux 2.32.1). Changes will remain in memory only, until you decide to write them. Be careful before using the write command. Device does not contain a recognized partition table. Created a new DOS disklabel with disk identifier 0x6f9ec9f0. Command (m for help): m Help: DOS (MBR) a toggle a bootable flag b edit nested BSD disklabel c toggle the dos compatibility flag Generic d delete a partition F list free unpartitioned space l list known partition types n add a new partition p print the partition table t change a partition type v verify the partition table i print information about a partition Misc m print this menu u change display/entry units x extra functionality (experts only) Script I load disk layout from sfdisk script file O dump disk layout to sfdisk script file Save & Exit w write table to disk and exit q quit without saving changes Create a new label g create a new empty GPT partition table G create a new empty SGI (IRIX) partition table o create a new empty DOS partition table s create a new empty Sun partition table Command (m for help): n Partition type p primary (0 primary, 0 extended, 4 free) e extended (container for logical partitions) Select (default p): p Partition number (1-4, default 1): First sector (2048-20971519, default 2048): Last sector, +sectors or +size{K,M,G,T,P} (2048-20971519, default 20971519): Created a new partition 1 of type 'Linux' and of size 10 GiB. Command (m for help): w The partition table has been altered. Calling ioctl() to re-read partition table. Syncing disks. [root@rac1 ~]# fdisk /dev/sdc Welcome to fdisk (util-linux 2.32.1). Changes will remain in memory only, until you decide to write them. Be careful before using the write command. Device does not contain a recognized partition table. Created a new DOS disklabel with disk identifier 0xe7c7d1b9. Command (m for help): n Partition type p primary (0 primary, 0 extended, 4 free) e extended (container for logical partitions) Select (default p): p Partition number (1-4, default 1): First sector (2048-20971519, default 2048): Last sector, +sectors or +size{K,M,G,T,P} (2048-20971519, default 20971519): Created a new partition 1 of type 'Linux' and of size 10 GiB. Command (m for help): w The partition table has been altered. Calling ioctl() to re-read partition table. Syncing disks. [root@rac1 ~]# fdisk /dev/sdd Welcome to fdisk (util-linux 2.32.1). Changes will remain in memory only, until you decide to write them. Be careful before using the write command. Device does not contain a recognized partition table. Created a new DOS disklabel with disk identifier 0x0541b9c6. Command (m for help): n Partition type p primary (0 primary, 0 extended, 4 free) e extended (container for logical partitions) Select (default p): p Partition number (1-4, default 1): First sector (2048-20971519, default 2048): Last sector, +sectors or +size{K,M,G,T,P} (2048-20971519, default 20971519): Created a new partition 1 of type 'Linux' and of size 10 GiB. Command (m for help): w The partition table has been altered. Calling ioctl() to re-read partition table. Syncing disks. [root@rac1 ~]# fdisk -l /dev/sdb Disk /dev/sdb: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x6f9ec9f0 Device Boot Start End Sectors Size Id Type /dev/sdb1 2048 20971519 20969472 10G 83 Linux [root@rac1 ~]# fdisk -l /dev/sdc Disk /dev/sdc: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0xe7c7d1b9 Device Boot Start End Sectors Size Id Type /dev/sdc1 2048 20971519 20969472 10G 83 Linux [root@rac1 ~]# fdisk -l /dev/sdd Disk /dev/sdd: 10 GiB, 10737418240 bytes, 20971520 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: dos Disk identifier: 0x0541b9c6 Device Boot Start End Sectors Size Id Type /dev/sdd1 2048 20971519 20969472 10G 83 Linux [root@rac1 Oracle 21c]# id uid=0(root) gid=0(root) groups=0(root) [root@rac1 Oracle 21c]# oracleasm createdisk OCRDISK1 /dev/sdb1 Writing disk header: done Instantiating disk: done [root@rac1 Oracle 21c]# oracleasm createdisk OCRDISK2 /dev/sdc1 Writing disk header: done Instantiating disk: done [root@rac1 Oracle 21c]# oracleasm createdisk OCRDISK3 /dev/sdd1 Writing disk header: done Instantiating disk: done |

#ssh configuration for grid user on both node: Node1: [grid@rac1 ~]$ rm -rf .ssh [grid@rac1 ~]$ mkdir .ssh [grid@rac1 ~]$ chmod 700 .ssh [grid@rac1 ~]$ cd .ssh [grid@rac1 .ssh]$ ssh-keygen -t rsa Generating public/private rsa key pair. Enter file in which to save the key (/home/grid/.ssh/id_rsa): Enter passphrase (empty for no passphrase): Enter same passphrase again: Your identification has been saved in /home/grid/.ssh/id_rsa. Your public key has been saved in /home/grid/.ssh/id_rsa.pub. The key fingerprint is: SHA256:Wh0g51+87cEgTuPsV4xfYUr8OwDkFzOPCLCp6/9xmPQ grid@rac1.localdomain The key's randomart image is: +---[RSA 3072]----+ | ..+. . + | | +o.+.o * | | o. =++= + | | . B =+B+ .| | . S.* oo*..| | .o..+ +.o.| | .. +.E. oo | | . o. .| | ..... | +----[SHA256]-----+ [grid@rac1 .ssh]$ ssh-keygen -t dsa Generating public/private dsa key pair. Enter file in which to save the key (/home/grid/.ssh/id_dsa): Enter passphrase (empty for no passphrase): Enter same passphrase again: Your identification has been saved in /home/grid/.ssh/id_dsa. Your public key has been saved in /home/grid/.ssh/id_dsa.pub. The key fingerprint is: SHA256://6QZ2gvCr4xk8Bhm+djuO7kkIc8jVgSo+rEQ0YqAQ8 grid@rac1.localdomain The key's randomart image is: +---[DSA 1024]----+ |E | |.o | |..+ o | |oo o o + | |+o. . = S | |* = = = o o | |.+. B = X . = o | |o . * + * o.= | | . o= o..oooo | +----[SHA256]-----+ [grid@rac1 .ssh]$ cat *.pub >> authorized_keys.rac1 [grid@rac1 .ssh]$ ll -rw-r--r-- 1 grid oinstall 1186 Jun 18 22:59 authorized_keys.rac1 -rw------- 1 grid oinstall 1393 Jun 18 22:59 id_dsa -rw-r--r-- 1 grid oinstall 611 Jun 18 22:59 id_dsa.pub -rw------- 1 grid oinstall 2610 Jun 18 22:58 id_rsa -rw-r--r-- 1 grid oinstall 575 Jun 18 22:58 id_rsa.pub [grid@rac1 .ssh]$ scp authorized_keys.rac1 grid@rac2:/home/grid/.ssh/ The authenticity of host 'rac2 (10.20.30.102)' can't be established. ECDSA key fingerprint is SHA256:paSUsPHPoUwF04C4TJffskwngg82TS389hoEYRvbWJ4. Are you sure you want to continue connecting (yes/no/[fingerprint])? yes Warning: Permanently added 'rac2,10.20.30.102' (ECDSA) to the list of known hosts. grid@rac2's password: authorized_keys.rac1 100% 1186 1.6MB/s 00:00 [grid@rac1 .ssh]$ ll -rw-r--r-- 1 grid oinstall 1186 Jun 18 22:59 authorized_keys.rac1 -rw-r--r-- 1 grid oinstall 1186 Jun 18 23:00 authorized_keys.rac2 -rw------- 1 grid oinstall 1393 Jun 18 22:59 id_dsa -rw-r--r-- 1 grid oinstall 611 Jun 18 22:59 id_dsa.pub -rw------- 1 grid oinstall 2610 Jun 18 22:58 id_rsa -rw-r--r-- 1 grid oinstall 575 Jun 18 22:58 id_rsa.pub -rw-r--r-- 1 grid oinstall 179 Jun 18 23:00 known_hosts [grid@rac1 .ssh]$ cd $HOME/.ssh [grid@rac1 .ssh]$ cat *.rac* >> authorized_keys [grid@rac1 .ssh]$ chmod 600 authorized_keys [grid@rac1 .ssh]$ ll -rw------- 1 grid oinstall 2372 Jun 18 23:01 authorized_keys -rw-r--r-- 1 grid oinstall 1186 Jun 18 22:59 authorized_keys.rac1 -rw-r--r-- 1 grid oinstall 1186 Jun 18 23:00 authorized_keys.rac2 -rw------- 1 grid oinstall 1393 Jun 18 22:59 id_dsa -rw-r--r-- 1 grid oinstall 611 Jun 18 22:59 id_dsa.pub -rw------- 1 grid oinstall 2610 Jun 18 22:58 id_rsa -rw-r--r-- 1 grid oinstall 575 Jun 18 22:58 id_rsa.pub -rw-r--r-- 1 grid oinstall 179 Jun 18 23:00 known_hosts Node2: [grid@rac2 ~]$ cd $HOME [grid@rac2 ~]$ pwd /home/grid [grid@rac2 ~]$ mkdir .ssh [grid@rac2 ~]$ chmod 700 .ssh [grid@rac2 ~]$ cd .ssh [grid@rac2 .ssh]$ ssh-keygen -t rsa Generating public/private rsa key pair. Enter file in which to save the key (/home/grid/.ssh/id_rsa): Enter passphrase (empty for no passphrase): Enter same passphrase again: Your identification has been saved in /home/grid/.ssh/id_rsa. Your public key has been saved in /home/grid/.ssh/id_rsa.pub. The key fingerprint is: SHA256:KEuM3Mq0C0JFkbRyAKlVVU96WRoNeCtVdJrtoZNoK5E grid@rac2.localdomain The key's randomart image is: +---[RSA 3072]----+ |oo.=+.....+=+ . | |. +.. .+o=.= | |.o + .o=.o o | |..++ ..o.. + . | | .+ = . E.o + . | |.o + o o . . | |o + . . . | |.. . . | | . | +----[SHA256]-----+ [grid@rac2 .ssh]$ ssh-keygen -t dsa Generating public/private dsa key pair. Enter file in which to save the key (/home/grid/.ssh/id_dsa): Enter passphrase (empty for no passphrase): Enter same passphrase again: Your identification has been saved in /home/grid/.ssh/id_dsa. Your public key has been saved in /home/grid/.ssh/id_dsa.pub. The key fingerprint is: SHA256:QcEIHs/2Pqdwvrk458WufjiEcFfjD1SZpt00s5/n4Yw grid@rac2.localdomain The key's randomart image is: +---[DSA 1024]----+ | o. oo. ..o | | . +... + + + | | . + .+ = o + | | ......+ . o | | o oS o ..| | .... . oo| | ..+.+ +.o| | .=+B. E o.| | .=X*. | +----[SHA256]-----+ [grid@rac2 .ssh]$ cat *.pub >> authorized_keys.rac2 [grid@rac2 .ssh]$ ll -rw-r--r-- 1 grid oinstall 1186 Jun 18 22:59 authorized_keys.rac2 -rw------- 1 grid oinstall 1393 Jun 18 22:59 id_dsa -rw-r--r-- 1 grid oinstall 611 Jun 18 22:59 id_dsa.pub -rw------- 1 grid oinstall 2610 Jun 18 22:58 id_rsa -rw-r--r-- 1 grid oinstall 575 Jun 18 22:58 id_rsa.pub -rw-r--r-- 1 grid oinstall 179 Jun 18 22:57 known_hosts [grid@rac2 .ssh]$ ll -rw-r--r-- 1 grid oinstall 1186 Jun 18 23:00 authorized_keys.rac1 -rw-r--r-- 1 grid oinstall 1186 Jun 18 22:59 authorized_keys.rac2 -rw------- 1 grid oinstall 1393 Jun 18 22:59 id_dsa -rw-r--r-- 1 grid oinstall 611 Jun 18 22:59 id_dsa.pub -rw------- 1 grid oinstall 2610 Jun 18 22:58 id_rsa -rw-r--r-- 1 grid oinstall 575 Jun 18 22:58 id_rsa.pub -rw-r--r-- 1 grid oinstall 179 Jun 18 22:57 known_hosts [grid@rac2 .ssh]$ scp authorized_keys.rac2 grid@rac1:/home/grid/.ssh/ grid@rac1's password: authorized_keys.rac2 100% 1186 2.0MB/s 00:00 [grid@rac2 .ssh]$ ll -rw-r--r-- 1 grid oinstall 1186 Jun 18 23:00 authorized_keys.rac1 -rw-r--r-- 1 grid oinstall 1186 Jun 18 22:59 authorized_keys.rac2 -rw------- 1 grid oinstall 1393 Jun 18 22:59 id_dsa -rw-r--r-- 1 grid oinstall 611 Jun 18 22:59 id_dsa.pub -rw------- 1 grid oinstall 2610 Jun 18 22:58 id_rsa -rw-r--r-- 1 grid oinstall 575 Jun 18 22:58 id_rsa.pub -rw-r--r-- 1 grid oinstall 179 Jun 18 22:57 known_hosts [grid@rac2 .ssh]$ cd $HOME/.ssh [grid@rac2 .ssh]$ cat *.rac* >> authorized_keys [grid@rac2 .ssh]$ chmod 600 authorized_keys [grid@rac2 .ssh]$ ll -rw------- 1 grid oinstall 2372 Jun 18 23:01 authorized_keys -rw-r--r-- 1 grid oinstall 1186 Jun 18 23:00 authorized_keys.rac1 -rw-r--r-- 1 grid oinstall 1186 Jun 18 22:59 authorized_keys.rac2 -rw------- 1 grid oinstall 1393 Jun 18 22:59 id_dsa -rw-r--r-- 1 grid oinstall 611 Jun 18 22:59 id_dsa.pub -rw------- 1 grid oinstall 2610 Jun 18 22:58 id_rsa -rw-r--r-- 1 grid oinstall 575 Jun 18 22:58 id_rsa.pub -rw-r--r-- 1 grid oinstall 179 Jun 18 22:57 known_hosts [grid@rac1 .ssh]$ ssh rac1 The authenticity of host 'rac1 (10.20.30.101)' can't be established. ECDSA key fingerprint is SHA256:paSUsPHPoUwF04C4TJffskwngg82TS389hoEYRvbWJ4. Are you sure you want to continue connecting (yes/no/[fingerprint])? yes Warning: Permanently added 'rac1,10.20.30.101' (ECDSA) to the list of known hosts. Activate the web console with: systemctl enable --now cockpit.socket This system is not registered to Red Hat Insights. See https://cloud.redhat.com/ To register this system, run: insights-client --register Last login: Sat Jun 18 22:57:45 2022 from 10.20.30.102 [grid@rac1 ~]$ ssh rac2 Activate the web console with: systemctl enable --now cockpit.socket This system is not registered to Red Hat Insights. See https://cloud.redhat.com/ To register this system, run: insights-client --register Last login: Sat Jun 18 22:57:33 2022 from 10.20.30.101 [grid@rac2 ~]$ ssh rac1 Activate the web console with: systemctl enable --now cockpit.socket This system is not registered to Red Hat Insights. See https://cloud.redhat.com/ To register this system, run: insights-client --register Last login: Sat Jun 18 23:03:35 2022 from 10.20.30.101 grid@rac2 .ssh]$ ssh rac2 The authenticity of host 'rac2 (10.20.30.102)' can't be established. ECDSA key fingerprint is SHA256:paSUsPHPoUwF04C4TJffskwngg82TS389hoEYRvbWJ4. Are you sure you want to continue connecting (yes/no/[fingerprint])? yes Warning: Permanently added 'rac2,10.20.30.102' (ECDSA) to the list of known hosts. Activate the web console with: systemctl enable --now cockpit.socket This system is not registered to Red Hat Insights. See https://cloud.redhat.com/ To register this system, run: insights-client --register Last login: Sat Jun 18 23:03:37 2022 from 10.20.30.101 [grid@rac2 ~]$ ssh rac1 Activate the web console with: systemctl enable --now cockpit.socket This system is not registered to Red Hat Insights. See https://cloud.redhat.com/ To register this system, run: insights-client --register Last login: Sat Jun 18 23:03:46 2022 from 10.20.30.102 [grid@rac1 ~]$ [grid@rac1 ~]$ ssh rac2 Activate the web console with: systemctl enable --now cockpit.socket This system is not registered to Red Hat Insights. See https://cloud.redhat.com/ To register this system, run: insights-client --register Last login: Sat Jun 18 23:04:00 2022 from 10.20.30.102 |

Bước 10: Cài đặt và cấu hình GRID

1) Sao chép cơ sở hạ tầng GRID vào máy chủ đích trong thư mục GRID_HOME vì đây là bản sao ảnh gốc (Gold Image Copy setup). Đăng nhập với tư cách người dùng grid và giải nén các tệp cài đặt GRID, bạn sẽ nhận được các tệp nhị phân HOME hoàn chỉnh trong thư mục GRID_HOME.

2) Chạy cluvfy và khắc phục mọi sự cố.

3) Bắt đầu cài đặt GRID kèm bản vá.

Hãy giữ tất cả phần mềm và các tệp RPM trong một thư mục chung và thiết lập thư mục đó ở chế độ chia sẻ.